归一化的原理

归一化就是把你需要处理的数据经过处理后(通过某种算法)限制在你需要的一定范围内,让权重变为统一的过程,其目的就是将不同尺度上的评判结果统一到一个尺度上,从而可以作比较,作计算。首先归一化是为了后面数据处理的方便,其次是保正程序运行时收敛加快。

归一化的方法

1.线性函数转换

说明: x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最大值和最小值。

1 | def autoNorm(dataSet): |

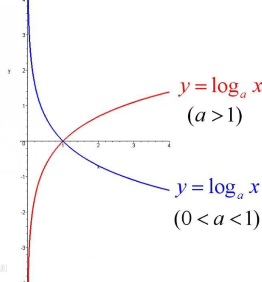

2.对数函数转换

说明: 以10为底的对数函数转换。

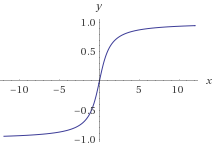

3.反余切函数转换

在统计学中,归一化的具体作用是归纳统一样本的统计分布性。归一化在0-1之间是统计的概率分布,归一化在 -1 — +1之间是统计的坐标分布。